-

Compteur de contenus

29 097 -

Inscription

-

Dernière visite

-

Jours gagnés

994

Type de contenu

Profils

Forums

Calendrier

Tout ce qui a été posté par Ldfa

-

durée de lecture : 1 minQue vous soyez développeur, chercheur en sécu ou simple bidouilleur, vous avez besoin de 2 choses dans la vie pour être équilibré et heureux : Une bonne hygiène personnelle Et bien sûr d’un éditeur hexadécimal qui tient la route Alors pour l’hygiène, je ne peux pas trop vous aider. Mais pour l’autre truc, on va causer sérieux avec ImHex. Il s’agit d’un éditeur hexa conçu pour, je cite, « les gens qui tiennent à leurs rétines« . En effet, cet éditeur, dispo sous macOS, Linux et Windows, a été conçu pour apporter un maximum de confort visuel, notamment pour ceux qui travaillent tard le soir. Il dispose de nombreuses fonctionnalités très cool comme des capacités de patching et de gestion des patchs, la recherche de tous types de chaines de caractères, la mise en surbrillance colorée, les bookmarks, du désassemblage, un visualisateur de constantes…etc. Ainsi que pleins d’outils pratiques comme une calculatrice, une table ASCII, ou un démangleur LLVM qui permet de rendre lisibles les noms et fonctions chiffrées par le compilateur LLVM. ImHex utilise également un modèle de langage inspiré du C++ et prend en charge de nombreux types de données, tels que les tableaux, les pointeurs, les énumérations, les champs binaires, les formats little et big endian, les conditions et bien plus encore… Et évidemment, différents thèmes sont disponibles, y compris un thème clair pour ceux qui préfèrent et vous pouvez régler la taille et l’aspect de la police de caractère utilisé par l’outil. À découvrir ici ! Merci à Letsar pour le partage ! Afficher l’article complet

-

durée de lecture : 1 minQue vous soyez développeur, chercheur en sécu ou simple bidouilleur, vous avez besoin de 2 choses dans la vie pour être équilibré et heureux : Une bonne hygiène personnelle Et bien sûr d’un éditeur hexadécimal qui tient la route Alors pour l’hygiène, je ne peux pas trop vous aider. Mais pour l’autre truc, on va causer sérieux avec ImHex. Il s’agit d’un éditeur hexa conçu pour, je cite, « les gens qui tiennent à leurs rétines« . En effet, cet éditeur, dispo sous macOS, Linux et Windows, a été conçu pour apporter un maximum de confort visuel, notamment pour ceux qui travaillent tard le soir. Il dispose de nombreuses fonctionnalités très cool comme des capacités de patching et de gestion des patchs, la recherche de tous types de chaines de caractères, la mise en surbrillance colorée, les bookmarks, du désassemblage, un visualisateur de constantes…etc. Ainsi que pleins d’outils pratiques comme une calculatrice, une table ASCII, ou un démangleur LLVM qui permet de rendre lisibles les noms et fonctions chiffrées par le compilateur LLVM. ImHex utilise également un modèle de langage inspiré du C++ et prend en charge de nombreux types de données, tels que les tableaux, les pointeurs, les énumérations, les champs binaires, les formats little et big endian, les conditions et bien plus encore… Et évidemment, différents thèmes sont disponibles, y compris un thème clair pour ceux qui préfèrent et vous pouvez régler la taille et l’aspect de la police de caractère utilisé par l’outil. À découvrir ici ! Merci à Letsar pour le partage ! Afficher l’article complet

-

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

On a pas fini de rire (ou de pleurer) : https://www.01net.com/actualites/bard-ia-google-grosse-gaffe-commence-bien.html et https://www.numerama.com/tech/1263488-cette-erreur-de-bard-a-fait-perdre-100-milliards-de-dollars-a-google.html -

Pour ne plus tomber dans le piège des fake news - Korben.info

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 3 min C’est l’ami Rémouk qui me l’a fait remarqué lors du dernier Webosaures : Google News a intégré une section sur son site pour mettre en avant uniquement les « Fact Check« . Ces articles, rédigés par des médias considérés comme sérieux, reprennent les fausses affirmations qui trainent sur le net, et tentent d’en démêler le vrai du faux. Si je vous en parle aujourd’hui, c’est que je trouve ça cool pour plusieurs raisons. Tout d’abord, j’en peux plus de ces fake news, de ces ramassis de conneries et de tout ce que les assombris du bocal relaient toute la journée sur leurs réseaux sociaux ou sur des médias douteux. Je pense vraiment qu’on devrait faire fermer tous ces sites qui font la promotion de ces fausses informations tant cela fait des dégâts dans notre société. Et également, dans le respect et avec beaucoup de tendresse, écarteler les gens qui relaient ces fake news. Si je trouve ça bien que Google mette ce genre de chose en avant, c’est parce qu’il faut se rendre à l’évidence : La plupart des gens sont de grosses feignasses quand il s’agit de vérifier une information. Par manque de temps bien sûr, et parce qu’à l’école, on ne leur a jamais vraiment appris à faire preuve d’esprit critique ou à aller au-delà de ce qu’on peut lire. Et même si je me souviens avoir appris à décomposer un article de presse, je n’ai jamais dans le cadre scolaire, appris à comprendre et analyser une information ou à déterminer la fiabilité d’un relai d’information. Ainsi, dans la tête de la plupart d’entre nous, un article sur FranceTV Info, sur JeanMarcMorandini, sur FranceSoir, ou encore sur une page Facebook quelconque, a la même valeur, la même crédibilité car : « Vue sur Internet ». Donc comme les gens sont ce qu’ils sont, et qu’on ne va pas se transformer en debunkeur du jour au lendemain, encore moins en croisant des sources, c’est plutôt cool qu’on mette ce genre d’information directement sous le nez de tout le monde. Je tiens d’ailleurs à saluer les journalistes qui font, contre vents et marées, ce travail abominable de fact checking qui consiste dans la plupart des cas, à rappeler des évidences scientifiques en le sourçant pour se faire ensuite insulter sur Twitter par des centaines d’abrutis. Alors même si je sais que les esprits les plus stupides proclament à longueur de journée que « EUX, font leurs propres recherches » et que l’ouverture de leur bouche est inversement proportionnelle à leur ouverture d’esprit, la vérité, c’est qu’ils cherchent que dalle et se contentent de répéter bêtement les âneries de leurs influenceurs hyper-stars (je vous laisse deviner lesquels). Alors pour ceux qui peuvent encore être un peu sauvés, car pas dans la croyance, et qui se posent effectivement des questions, j’ai ce qu’il vous faut. Grâce à Google, vous allez pouvoir vérifier si toutes les « informations » que Tata Corinne ou votre collègue Thierry relaient sur Facebook / Twitter / TikTok sont fondées. Ou si c’est juste un énorme étron mental qu’ils tentent d’insérer dans votre cerveau sans même en avoir conscience. Cela se passe sur ce site qui est tout simplement un moteur de recherche de fact checking. Vous tapez le sujet qui vous tracasse et vous aurez des informations vérifiées et contre-vérifiées par des professionnels afin de pouvoir vraiment comprendre de quoi il en retourne. Bref, vous n’aurez plus d’excuse pour lutter contre la bêtise qui vous entoure ! Et au nom de tous, merci d’avance pour vos efforts. Afficher l’article complet -

Pour ne plus tomber dans le piège des fake news - Korben.info

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 3 minC’est l’ami Rémouk qui me l’a fait remarqué lors du dernier Webosaures : Google News a intégré une section sur son site pour mettre en avant uniquement les « Fact Check« . Ces articles, rédigés par des médias considérés comme sérieux, reprennent les fausses affirmations qui trainent sur le net, et tentent d’en démêler le vrai du faux. Si je vous en parle aujourd’hui, c’est que je trouve ça cool pour plusieurs raisons. Tout d’abord, j’en peux plus de ces fake news, de ces ramassis de conneries et de tout ce que les assombris du bocal relaient toute la journée sur leurs réseaux sociaux ou sur des médias douteux. Je pense vraiment qu’on devrait faire fermer tous ces sites qui font la promotion de ces fausses informations tant cela fait des dégâts dans notre société. Et également, dans le respect et avec beaucoup de tendresse, écarteler les gens qui relaient ces fake news. Si je trouve ça bien que Google mette ce genre de chose en avant, c’est parce qu’il faut se rendre à l’évidence : La plupart des gens sont de grosses feignasses quand il s’agit de vérifier une information. Par manque de temps bien sûr, et parce qu’à l’école, on ne leur a jamais vraiment appris à faire preuve d’esprit critique ou à aller au-delà de ce qu’on peut lire. Et même si je me souviens avoir appris à décomposer un article de presse, je n’ai jamais dans le cadre scolaire, appris à comprendre et analyser une information ou à déterminer la fiabilité d’un relai d’information. Ainsi, dans la tête de la plupart d’entre nous, un article sur FranceTV Info, sur JeanMarcMorandini, sur FranceSoir, ou encore sur une page Facebook quelconque, a la même valeur, la même crédibilité car : « Vue sur Internet ». Donc comme les gens sont ce qu’ils sont, et qu’on ne va pas se transformer en debunkeur du jour au lendemain, encore moins en croisant des sources, c’est plutôt cool qu’on mette ce genre d’information directement sous le nez de tout le monde. Je tiens d’ailleurs à saluer les journalistes qui font, contre vents et marées, ce travail abominable de fact checking qui consiste dans la plupart des cas, à rappeler des évidences scientifiques en le sourçant pour se faire ensuite insulter sur Twitter par des centaines d’abrutis. Alors même si je sais que les esprits les plus stupides proclament à longueur de journée que « EUX, font leurs propres recherches » et que l’ouverture de leur bouche est inversement proportionnelle à leur ouverture d’esprit, la vérité, c’est qu’ils cherchent que dalle et se contentent de répéter bêtement les âneries de leurs influenceurs hyper-stars (je vous laisse deviner lesquels). Alors pour ceux qui peuvent encore être un peu sauvés, car pas dans la croyance, et qui se posent effectivement des questions, j’ai ce qu’il vous faut. Grâce à Google, vous allez pouvoir vérifier si toutes les « informations » que Tata Corinne ou votre collègue Thierry relaient sur Facebook / Twitter / TikTok sont fondées. Ou si c’est juste un énorme étron mental qu’ils tentent d’insérer dans votre cerveau sans même en avoir conscience. Cela se passe sur ce site qui est tout simplement un moteur de recherche de fact checking. Vous tapez le sujet qui vous tracasse et vous aurez des informations vérifiées et contre-vérifiées par des professionnels afin de pouvoir vraiment comprendre de quoi il en retourne. Bref, vous n’aurez plus d’excuse pour lutter contre la bêtise qui vous entoure ! Et au nom de tous, merci d’avance pour vos efforts. Afficher l’article complet -

Pour ne plus tomber dans le piège des fake news - Korben.info

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 3 minC’est l’ami Rémouk qui me l’a fait remarqué lors du dernier Webosaures : Google News a intégré une section sur son site pour mettre en avant uniquement les « Fact Check« . Ces articles, rédigés par des médias considérés comme sérieux, reprennent les fausses affirmations qui trainent sur le net, et tentent d’en démêler le vrai du faux. Si je vous en parle aujourd’hui, c’est que je trouve ça cool pour plusieurs raisons. Tout d’abord, j’en peux plus de ces fake news, de ces ramassis de conneries et de tout ce que les assombris du bocal relaient toute la journée sur leurs réseaux sociaux ou sur des médias douteux. Je pense vraiment qu’on devrait faire fermer tous ces sites qui font la promotion de ces fausses informations tant cela fait des dégâts dans notre société. Et également, dans le respect et avec beaucoup de tendresse, écarteler les gens qui relaient ces fake news. Si je trouve ça bien que Google mette ce genre de chose en avant, c’est parce qu’il faut se rendre à l’évidence : La plupart des gens sont de grosses feignasses quand il s’agit de vérifier une information. Par manque de temps bien sûr, et parce qu’à l’école, on ne leur a jamais vraiment appris à faire preuve d’esprit critique ou à aller au-delà de ce qu’on peut lire. Et même si je me souviens avoir appris à décomposer un article de presse, je n’ai jamais dans le cadre scolaire, appris à comprendre et analyser une information ou à déterminer la fiabilité d’un relai d’information. Ainsi, dans la tête de la plupart d’entre nous, un article sur FranceTV Info, sur JeanMarcMorandini, sur FranceSoir, ou encore sur une page Facebook quelconque, a la même valeur, la même crédibilité car : « Vue sur Internet ». Donc comme les gens sont ce qu’ils sont, et qu’on ne va pas se transformer en debunkeur du jour au lendemain, encore moins en croisant des sources, c’est plutôt cool qu’on mette ce genre d’information directement sous le nez de tout le monde. Je tiens d’ailleurs à saluer les journalistes qui font, contre vents et marées, ce travail abominable de fact checking qui consiste dans la plupart des cas, à rappeler des évidences scientifiques en le sourçant pour se faire ensuite insulter sur Twitter par des centaines d’abrutis. Alors même si je sais que les esprits les plus stupides proclament à longueur de journée que « EUX, font leurs propres recherches » et que l’ouverture de leur bouche est inversement proportionnelle à leur ouverture d’esprit, la vérité, c’est qu’ils cherchent que dalle et se contentent de répéter bêtement les âneries de leurs influenceurs hyper-stars (je vous laisse deviner lesquels). Alors pour ceux qui peuvent encore être un peu sauvés, car pas dans la croyance, et qui se posent effectivement des questions, j’ai ce qu’il vous faut. Grâce à Google, vous allez pouvoir vérifier si toutes les « informations » que Tata Corinne ou votre collègue Thierry relaient sur Facebook / Twitter / TikTok sont fondées. Ou si c’est juste un énorme étron mental qu’ils tentent d’insérer dans votre cerveau sans même en avoir conscience. Cela se passe sur ce site qui est tout simplement un moteur de recherche de fact checking. Vous tapez le sujet qui vous tracasse et vous aurez des informations vérifiées et contre-vérifiées par des professionnels afin de pouvoir vraiment comprendre de quoi il en retourne. Bref, vous n’aurez plus d’excuse pour lutter contre la bêtise qui vous entoure ! Et au nom de tous, merci d’avance pour vos efforts. Afficher l’article complet -

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

Le nouveau Bing dopé à l'IA, c'est par ici : https://www.01net.com/astuces/comment-acceder-avant-tout-le-monde-au-nouveau-bing-avec-chatgpt.html et https://www.01net.com/actualites/chatgpt-microsoft-bing-revolutionner-recherche-webet-tuer-google.html et https://www.it-connect.fr/cest-officiel-microsoft-va-doper-bing-et-edge-avec-un-chatbot-ia/ -

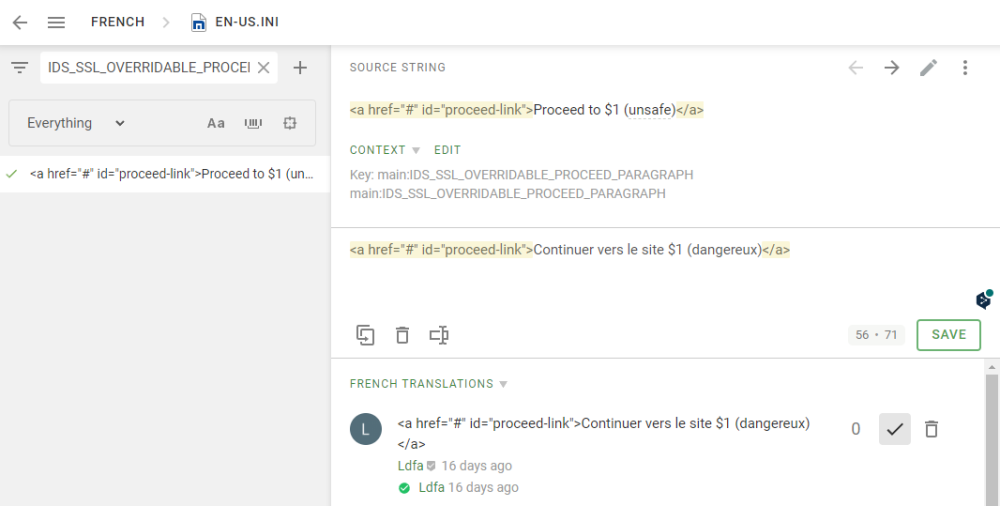

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

J'ai trouvé un bug dans le fichier de traduction française généré par Crowdin : Cette traduction apparait dans le fichier fr.ini ainsi et ça génère un bug de fonctionnement de la page : IDS_SSL_OVERRIDABLE_PROCEED_PARAGRAPH="<a href=\"#\" id=\"proceed-link\">Continuer vers le site $1 (dangereux)</a>" Crowdin rajoute des guillemets en début et fin de phrase et des \ devant les guillemets présents, alors que la ligne doit être : IDS_SSL_OVERRIDABLE_PROCEED_PARAGRAPH=<a href="#" id="proceed-link">Continuer vers le site $1 (dangereux)</a> Il y a malheureusement beaucoup de ligne qui comportent ce bug et je n'ai pas encore trouvé le réglage sur Crowdin qui permet de l'éviter... -

MAJ MAJ d'IP.Board en version 4.7.7

Ldfa a répondu à un(e) sujet de Ldfa dans Nouveautés du Site Maxthon-fr.com

Oui, c'est bien ça. -

Je viens de faire la MAJ d'IP.Board en version 4.7.7 qui apporte des ajouts et corrections de bugs/failles de sécurité. Si vous constatez des dysfonctionnements, de les signaler à la suite de ce message. Source : https://invisioncommunity.com/release-notes/

-

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

Elle est bien bonne celle là : https://www.clubic.com/pro/entreprises/google/actualite-456360-chatgpt-est-assez-doue-en-code-pour-etre-recrute-chez-google-avec-un-salaire-consequent.html -

Comme avec Maxthon 5, il y a une sauvegarde de l'accès rapide, des favoris et du remplissage magique. Pour Maxthon 6, le dossier se trouve dans %USERPROFILE%\AppData\Local\Maxthon\Application\User Data\Profile 1\Backups\QuickAccess\ Comme avec Maxthon 5, si tu as un compte Maxthon et que tu es connecté avec sur Maxthon 6, ces données sont synchronisées sur les serveurs de Maxthon. Cela signifie que même si tu n'a pas conservé les données sur ton disque dur, par exemple si tu changes d'ordinateur, les données seront synchronisées lors de ta 1ère connexion sur ton nouvel ordinateur. Tu peux également faire une sauvegarde de temps en temps du dossier %USERPROFILE%\AppData\Local\Maxthon\Application\User Data\ si tu le souhaites.

- 8 réponses

-

- Dépannage

- Trucs et astuces

-

(et 1 en plus)

Étiqueté avec :

-

Avoir tous les favoris de l'accès rapide en cas de mauvaises manipes

Ldfa a répondu à un(e) sujet de franz dans Questions et astuces sur Mx6 & Mx7

Comme avec Maxthon 5, il y a une sauvegarde de l'accès rapide, des favoris et du remplissage magique. Pour Maxthon 6, le dossier se trouve dans %USERPROFILE%\AppData\Local\Maxthon\Application\User Data\Profile 1\Backups\QuickAccess\ Comme avec Maxthon 5, si tu as un compte Maxthon et que tu es connecté avec sur Maxthon 6, ces données sont synchronisées sur les serveurs de Maxthon. Cela signifie que même si tu n'a pas conservé les données sur ton disque dur, par exemple si tu changes d'ordinateur, les données seront synchronisées lors de ta 1ère connexion. Tu peux également faire une sauvegarde de temps en temps du dossier %USERPROFILE%\AppData\Local\Maxthon\Application\User Data\ si tu le souhaites. -

Chrome 110 passe toutes vos vidéos YouTube à la 4K grâce à NVIDIA - 01Net

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

Autre article sur le même sujet : https://www.tomshardware.fr/google-chrome-supporte-desormais-le-nvidia-rtx-video-super-resolution/ -

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

Teams évolue : https://www.tomsguide.fr/chatgpt-debarque-sur-microsoft-teams-vos-reunions-ne-seront-plus-les-memes/ -

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

La réponse de Google : https://www.silicon.fr/anthropic-reponse-google-chatgpt-457705.html et https://www.zdnet.fr/actualites/voici-enfin-la-reponse-de-google-a-chatgpt-google-bard-39953686.htm et https://www.silicon.fr/chatgpt-bataille-recherche-web-commence-457815.html et https://www.it-connect.fr/google-a-revele-bard-son-concurrent-de-chatgpt/ -

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

Bing : https://www.01net.com/actualites/microsoft-bing-version-chatgpt-arrive-apercu-cauchemar-google.html -

Chrome 110 passe toutes vos vidéos YouTube à la 4K grâce à NVIDIA - 01Net

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 2 minLa dernière version stable de Chrome, la 110.0.5481.77 précisément, intègre une nouveauté importante. On peut voir dans son code – publié publiquement – qu’elle active par défaut l’utilisation du « Nvidia Super Resolution », la nouvelle technologie d’upscaling vidéo présentée par le constructeur de cartes graphiques lors du CES 2023. © Overclock3dSi vous êtes un utilisateur de la NVIDIA Shield TV, vous serez en terrain connu. Il s’agit tout simplement d’une fonctionnalité capable d’augmenter automatiquement la définition d’une vidéo en 1080p pour la passer en 4K, par le biais d’une intelligence artificielle qui se charge d’améliorer la qualité de l’image du même temps. Elle rejoint le cadre des technologies d’upscaling déjà bien connues dans le milieu des téléviseurs, mais celle-ci s’intègre désormais directement dans votre navigateur web. En effet, qui dit Chrome dit Chromium, la base sur laquelle de nombreux navigateurs web sont développés aujourd’hui. Si Google Chrome est le premier à intégrer la technologie de NVIDIA, il y a fort à parier que Microsoft Edge et Opera soient également de la partie dans les jours qui suivent. Il existe tout de même plusieurs limitations. Déjà, la technologie RTX Video Super Resolution n’est supportée que par les cartes graphiques de série RTX 40 et 30 du constructeur. Il faut donc être équipé d’un GPU de dernière génération pour en profiter. Aussi, quand bien même NVIDIA met en avant la mise à l’échelle de 1080p à 4K, sa technologie peut upscale d’un flux 360p à 1440p en 4K jusqu’à 144 Hz de framerate. [embedded content] Mais on a bien du mal à imaginer un rendu propre sur des sources aussi vieilles et mal définies que de la 360p. Mieux vaudrait dès lors désactiver la fonctionnalité pour conserver en lisibilité. Et justement : l’accès au RTX Video Super Resolution est activé par défaut par les navigateurs, mais pas la fonctionnalité elle-même. Son activation se fera directement sur le panneau de contrôle NVIDIA. On espère que le développeur a prévu moult options pour nous permettre de définir précisément le comportement de sa mise à l’échelle, de manière à la réserver aux meilleurs flux. Cette technologie a énormément de potentiel sur PC. Outre le simple fait de pouvoir utiliser moins de bande passante au quotidien, elle pourrait être centrale dans le fait d’optimiser les flux vidéo du cloud gaming pour en augmenter toujours plus la qualité de rendu. Dommage que seul Nvidia se soit penché sur la question pour le moment : on espère qu’AMD et Intel planchent également sur leurs propres solutions pour la vidéo, et pourquoi pas en open source. Source : Overclock3d Afficher l’article complet -

Chrome 110 passe toutes vos vidéos YouTube à la 4K grâce à NVIDIA - 01Net

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 2 min La dernière version stable de Chrome, la 110.0.5481.77 précisément, intègre une nouveauté importante. On peut voir dans son code – publié publiquement – qu’elle active par défaut l’utilisation du « Nvidia Super Resolution », la nouvelle technologie d’upscaling vidéo présentée par le constructeur de cartes graphiques lors du CES 2023. © Overclock3d Si vous êtes un utilisateur de la NVIDIA Shield TV, vous serez en terrain connu. Il s’agit tout simplement d’une fonctionnalité capable d’augmenter automatiquement la définition d’une vidéo en 1080p pour la passer en 4K, par le biais d’une intelligence artificielle qui se charge d’améliorer la qualité de l’image du même temps. Elle rejoint le cadre des technologies d’upscaling déjà bien connues dans le milieu des téléviseurs, mais celle-ci s’intègre désormais directement dans votre navigateur web. En effet, qui dit Chrome dit Chromium, la base sur laquelle de nombreux navigateurs web sont développés aujourd’hui. Si Google Chrome est le premier à intégrer la technologie de NVIDIA, il y a fort à parier que Microsoft Edge et Opera soient également de la partie dans les jours qui suivent. Il existe tout de même plusieurs limitations. Déjà, la technologie RTX Video Super Resolution n’est supportée que par les cartes graphiques de série RTX 40 et 30 du constructeur. Il faut donc être équipé d’un GPU de dernière génération pour en profiter. Aussi, quand bien même NVIDIA met en avant la mise à l’échelle de 1080p à 4K, sa technologie peut upscale d’un flux 360p à 1440p en 4K jusqu’à 144 Hz de framerate. [embedded content] Mais on a bien du mal à imaginer un rendu propre sur des sources aussi vieilles et mal définies que de la 360p. Mieux vaudrait dès lors désactiver la fonctionnalité pour conserver en lisibilité. Et justement : l’accès au RTX Video Super Resolution est activé par défaut par les navigateurs, mais pas la fonctionnalité elle-même. Son activation se fera directement sur le panneau de contrôle NVIDIA. On espère que le développeur a prévu moult options pour nous permettre de définir précisément le comportement de sa mise à l’échelle, de manière à la réserver aux meilleurs flux. Cette technologie a énormément de potentiel sur PC. Outre le simple fait de pouvoir utiliser moins de bande passante au quotidien, elle pourrait être centrale dans le fait d’optimiser les flux vidéo du cloud gaming pour en augmenter toujours plus la qualité de rendu. Dommage que seul Nvidia se soit penché sur la question pour le moment : on espère qu’AMD et Intel planchent également sur leurs propres solutions pour la vidéo, et pourquoi pas en open source. Source : Overclock3d Afficher l’article complet -

Chrome 110 passe toutes vos vidéos YouTube à la 4K grâce à NVIDIA - 01Net

Ldfa a posté un sujet dans Mon Wallabag

durée de lecture : 2 minLa dernière version stable de Chrome, la 110.0.5481.77 précisément, intègre une nouveauté importante. On peut voir dans son code – publié publiquement – qu’elle active par défaut l’utilisation du « Nvidia Super Resolution », la nouvelle technologie d’upscaling vidéo présentée par le constructeur de cartes graphiques lors du CES 2023. © Overclock3dSi vous êtes un utilisateur de la NVIDIA Shield TV, vous serez en terrain connu. Il s’agit tout simplement d’une fonctionnalité capable d’augmenter automatiquement la définition d’une vidéo en 1080p pour la passer en 4K, par le biais d’une intelligence artificielle qui se charge d’améliorer la qualité de l’image du même temps. Elle rejoint le cadre des technologies d’upscaling déjà bien connues dans le milieu des téléviseurs, mais celle-ci s’intègre désormais directement dans votre navigateur web. En effet, qui dit Chrome dit Chromium, la base sur laquelle de nombreux navigateurs web sont développés aujourd’hui. Si Google Chrome est le premier à intégrer la technologie de NVIDIA, il y a fort à parier que Microsoft Edge et Opera soient également de la partie dans les jours qui suivent. Il existe tout de même plusieurs limitations. Déjà, la technologie RTX Video Super Resolution n’est supportée que par les cartes graphiques de série RTX 40 et 30 du constructeur. Il faut donc être équipé d’un GPU de dernière génération pour en profiter. Aussi, quand bien même NVIDIA met en avant la mise à l’échelle de 1080p à 4K, sa technologie peut upscale d’un flux 360p à 1440p en 4K jusqu’à 144 Hz de framerate. [embedded content] Mais on a bien du mal à imaginer un rendu propre sur des sources aussi vieilles et mal définies que de la 360p. Mieux vaudrait dès lors désactiver la fonctionnalité pour conserver en lisibilité. Et justement : l’accès au RTX Video Super Resolution est activé par défaut par les navigateurs, mais pas la fonctionnalité elle-même. Son activation se fera directement sur le panneau de contrôle NVIDIA. On espère que le développeur a prévu moult options pour nous permettre de définir précisément le comportement de sa mise à l’échelle, de manière à la réserver aux meilleurs flux. Cette technologie a énormément de potentiel sur PC. Outre le simple fait de pouvoir utiliser moins de bande passante au quotidien, elle pourrait être centrale dans le fait d’optimiser les flux vidéo du cloud gaming pour en augmenter toujours plus la qualité de rendu. Dommage que seul Nvidia se soit penché sur la question pour le moment : on espère qu’AMD et Intel planchent également sur leurs propres solutions pour la vidéo, et pourquoi pas en open source. Source : Overclock3d Afficher l’article complet -

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

Effectivement : https://www.zdnet.fr/actualites/chatgpt-devient-l-application-a-la-croissance-la-plus-rapide-de-tous-les-temps-39953618.htm -

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

Crowdin est finalement bien pratique et bien pensée. -

Mon nouvel ami qui sait tout sur tout #chatGPT - Korben.info

Ldfa a répondu à un(e) sujet de Ldfa dans Mon Wallabag

Un CatGPT à base d'IA de chat : https://www.clubic.com/technologies-d-avenir/intelligence-artificielle/actualite-456078-vous-avez-aime-chatgpt-decouvrez-catgpt.html -

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

@ernest As-tu toujours l'option Upload Translation ? -

Win Traduction française de Mx7 pour Windows

Ldfa a répondu à un(e) sujet de Ldfa dans Traductions françaises de Maxthon sur Crowdin

Je confirme, tout est rentré dans l'ordre, je vais voir si on peut pas enlever ce droit... Je crois que j'ai trouvé, je vais essayé de décocher ça.